大數據是近年來火熱的話題,企業紛紛想將散落的資料整合至資料倉儲 (Data Warehouse) ,並分析、訓練、再利用。特別是 SIEM ,隨著收集回來的數據量增長到巨量時,企業卻鮮少想到,原來資安數據也可以透過大數據的方式來分析並尋找潛在的威脅。

何謂大數據資安分析

透過分析大量的資安數據,以找出潛在的安全威脅和漏洞,並監測用於儲存和管理這些數據的相關系統和網路的安全。這種類型的分析涉及到使用各種工具和技術,包含機器學習、數據探勘和統計分析等,並檢測任何惡意活動或潛在的安全漏洞。

大數據資安分析的目標是為了提供企業必要的資訊,以便對系統及網路安全做出正確的決定,並檢測和回應資安威脅。隨著企業產生和儲存越來越多的機敏數據,威脅變得更加複雜和難以檢測,所以大數據資安分析通常涉及幾個關鍵步驟,包含收集和統整數據、擷取、轉換和清理 (ETL) ,並透過專門的工具和演算法來進行分析,再將分析結果用來提出建議,以提高更積極的措施來保護機敏數據和防止洩漏的風險。

結合 Microsoft Sentinel 與大數據資安分析

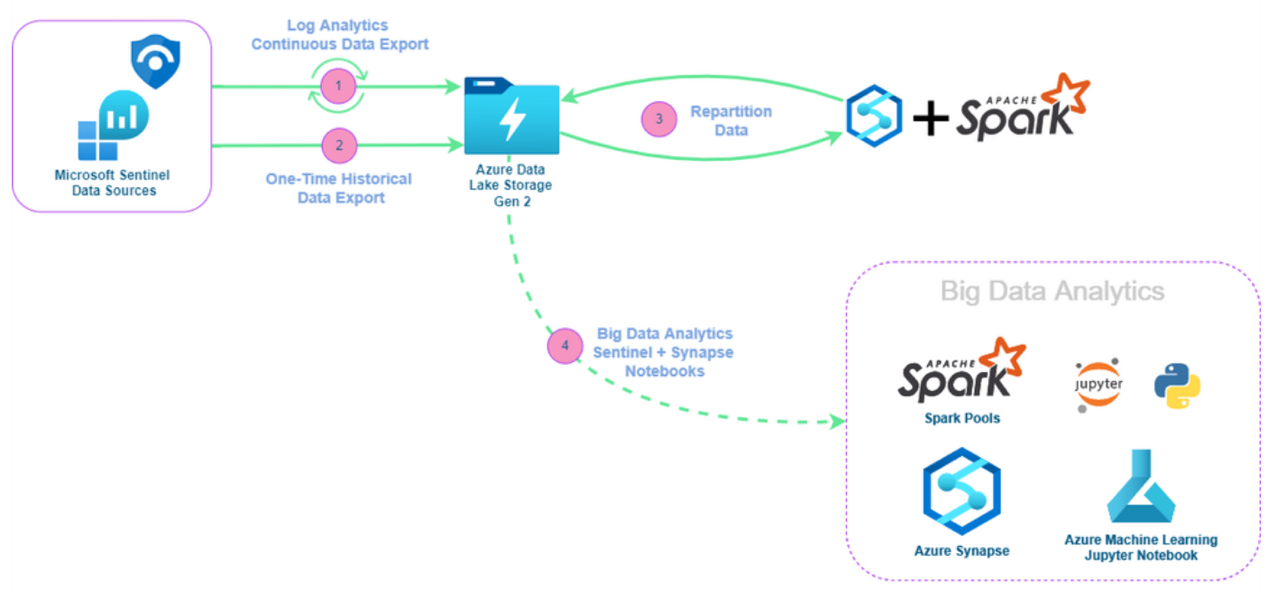

Microsoft Sentinel 中的資料主要是使用 KQL 和 Log Analytics 來作為查詢和分析工具。而透過

Microsoft Sentinel 與 Azure Synapse 、 Azure Machine Learning 的整合,將 Log Analytics 的巨量資安數據匯出至 Azure Data Lake Storage Gen2 儲存體圖一,再透過 Microsoft Sentinel 內建筆記本 (Notebooks) 選取樣板或自訂樣板後,就可以開始使用 Azure Synapse 所提供的巨量資料分析功能,讓 Apache Spark 分散式處理引擎執行機器學習、數據探勘和統計分析等功能,並由 SOC 分析師依據分析結果採取正確的措施。

圖一

圖一

使用 Azure Synapse Analytics 分析資安數據的好處

- 巨量安全性數據分析:可以使用成本優化、以及全託管的 Azure Synapse Apache Spark 計算集區

- 符合成本效益的數據湖 (Data Lake) 存取:透過 Azure Data Lake Storage Gen2 建置長遠的資料分析

- 彈性選擇數據整合來源:在資安工作流程中整合來自不同來源和格式的安全性數據

- PySpark - 基於 Python 的 API :利用 Spark 框架配合 Python,分析師可以直接使用 Python 程式語言,不用重新學習新的程式語言